Kontynuacja testów z serii: po multimodalności sprawdzamy, czy da się zbudować aplikację bez programowania

To jest kolejny artykuł z serii Wielka czwórka AI – Crash Test i naturalna kontynuacja tekstu z części pierwszej:

👉 https://www.zig.pl/baza-wiedzy/wielka-czworka-ai-crash-test-czesc-1-multimodalnosc

W tamtym materiale skonfrontowałem modele ChatGPT, Gemini, Claude i DeepSeek z zadaniem edycji obrazów — multimodalnym crash testem, który już pokazał, jak daleko technologia posunęła się od prostych generatorów do narzędzi „rozumiejących obraz z kontekstem”. Największe różnice ujawniły się tam w zachowaniu kontekstu i spójności detali.

Dziś, w drugiej części serii, sprawdzimy czy faktycznie, w 2026 roku: da się zbudować aplikację tylko z prompta — bez ani jednej linijki kodu napisanego ręcznie?

Dlaczego ten test?

W 2025 użytkownicy mogli być zadowoleni z generatorów kodu lub wizualnych makiet. W 2026 oczekiwania są inne: jeśli chcesz aplikację, AI ma dostarczyć ją w całości — realnie działającą, a nie wyglądającą jak koncept.

To nie test „który model lepiej wygeneruje UI” — to test:

- procesu produkcji aplikacji od zera,

- utrzymania spójności logiki po poprawkach,

- obsługi rzeczywistych danych i iteracji,

- oraz odporności na zmiany w specyfikacji.

Modele, które dziś testuję w tym zadaniu:

- ChatGPT 5.2 (OpenAI)

- Gemini 3 (Google)

- Claude Sonnet 4.5 (Anthropic)

- DeepSeek

Metodologia testu

Co oznacza „zero kodowania”

W teście zero kodowania nie dopuszczam:

- ręcznego debugowania w IDE,

- dopisywania fragmentów logiki,

- dostosowywania artefaktów poza instrukcjami modelu.

Model ma:

- prowadzić mnie krok po kroku,

- wygenerować wszystko, co konieczne do działającej aplikacji,

- uwzględnić zmiany w kolejnych iteracjach,

- dowieźć działający efekt (gotową aplikację z czytelnym UI i wszystkimi wymienionymi funkcjami).

Zadania główne - Timer do ćwiczeń

Polecenie testowe

Chciałbym stworzyć timer do ćwiczeń, gdzie mogę ustawić czas ćwiczenia i czas potrzebny na regenerację pomiędzy ćwiczeniami. Dodatkowo, chciałbym, żeby można było ustawiać ilość serii i czas pomiędzy seriami. Po ustawieniu timera i aktywacji powinien wyświetlać odliczany czas na całym ekranie i ostatnie 5 sekund zaznaczać sygnałem dźwiękowym. Utwórz kod html

Prompt był identyczny dla wszystkich modeli.

- Gemini 3 — wykonanie timera

Gemini był pierwszym narzędziem, które testowałem. Oryginalny kod został wygenerowany w React, w związku z chęcią pokazania tych aplikacji w artykule z możliwością ich testowania przez czytelników, poprosiłem o przepisanie do html’a. Gemini poradził sobie z tym zadaniem koncertowo, zachowując oryginalnie wygenerowany UX w React. Do kolejnych testów dodałem polecenie generowania kodu w html.

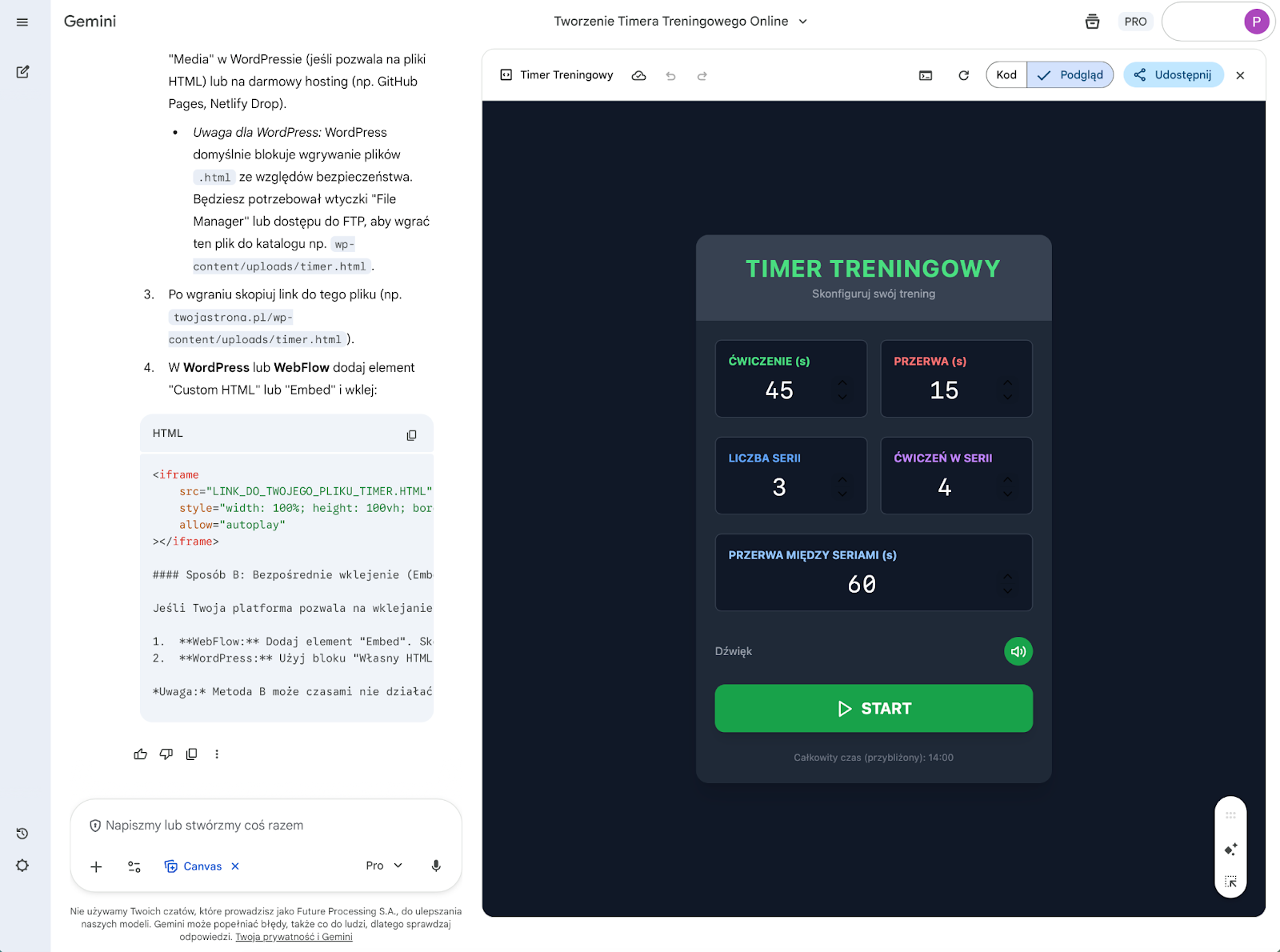

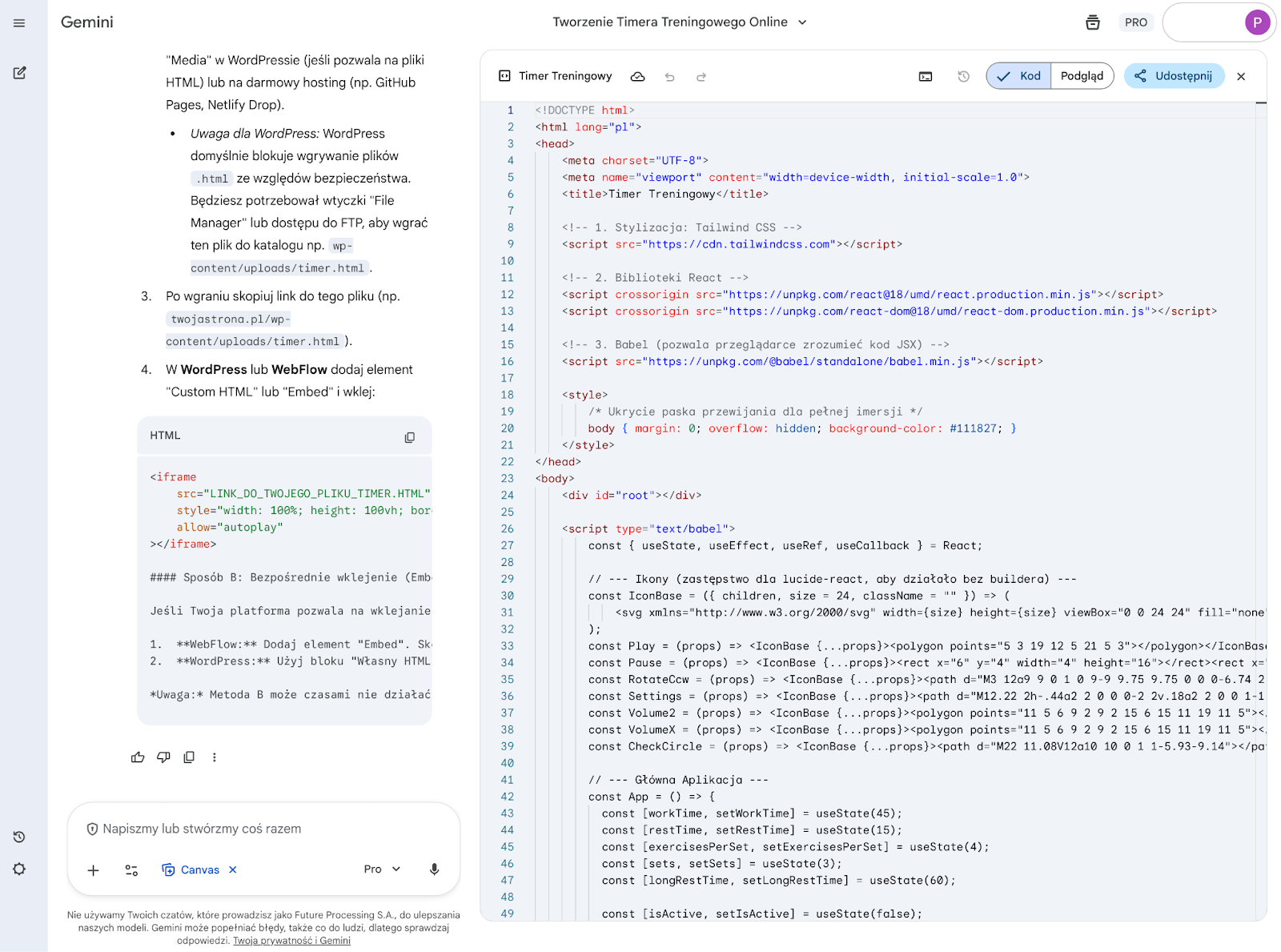

Gemini wprowadziło w marcu 2025 funkcję Canvas, która w trakcie roku poprzez kolejne aktualizacje, stała się potężnym narzędziem m.in do pracy nad tworzeniem i rozwijaniem aplikacji. Poniżej widok z Canvas:

Dzięki takiemu układowi, możemy na bieżąco testować tworzoną aplikację. A jeśli mamy wiedzę w obszarze języka, którym jest tworzone rozwiązanie, przełączamy na widok Kod i rozpoczynamy analizę/zmiany:

Rezultat

Poniżej działająca aplikacja, można testować:

Działające elementy, pozytywne uwagi

✅ UI timera

✅ Wszystkie funkcje opisane w instrukcji

✅ start/pauza/reset

✅ Gemini dodał ekran z czasem na przygotowanie się do ćwiczenia

✅ podsumowanie całego czasu serii ćwiczeń

✅ możliwość wyłączenia dźwięku

✅ poprawny sygnał dźwiękowy na 5 sekund przed końcem ćwiczenia

Problemy / niedociągnięcia

❌ żeby zatrzymać timer, trzeba przejść do ustawień, nie jest to jasne

❌ odliczanie jest do zera, przez co ostatnie 5 sekund zaczyna się kiedy na ekranie pojawia się cyfra 4

2) ChatGPT 5.2 — wykonanie timera

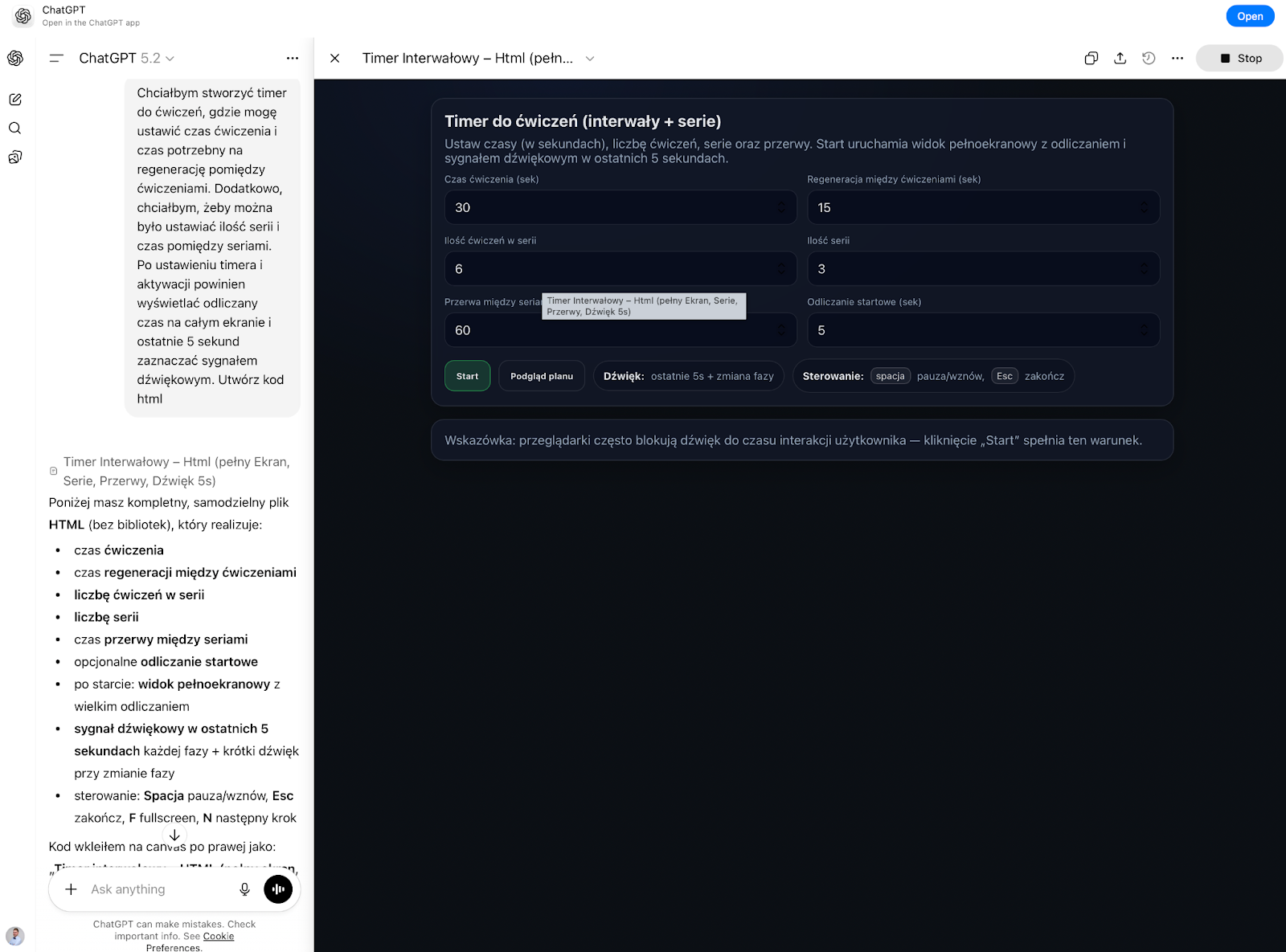

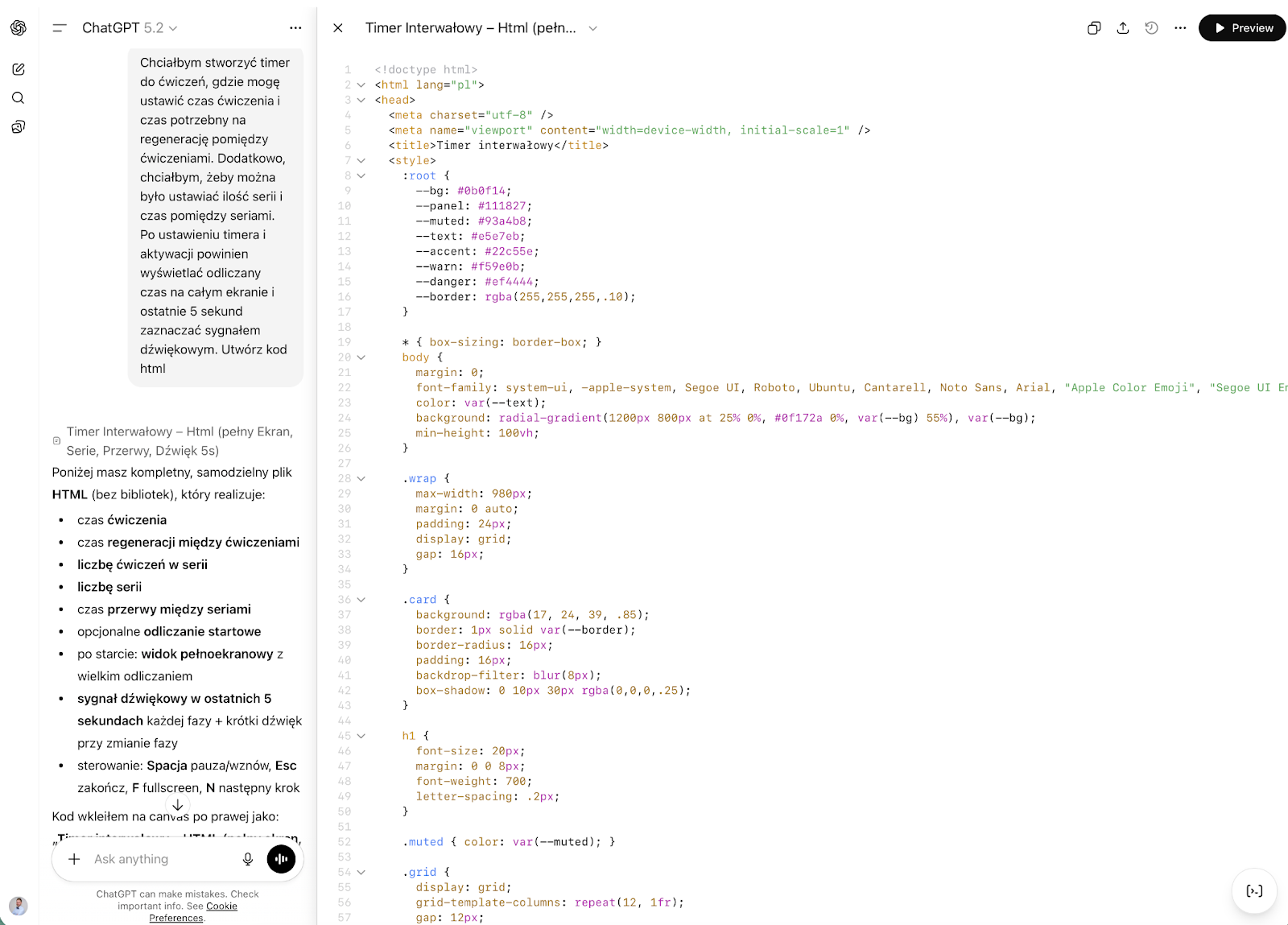

ChatGPT również ma funkcję Canvas, gdzie można podglądać wygenerowaną aplikację:

Jak również, przejść do edycji kodu:

Rezultat:

Możesz zmienić design na bardziej przyjazny i zgodny ze standardami UX?

Działające elementy, pozytywne uwagi:

✅ UI timera

✅ Wszystkie funkcje opisane w instrukcji

✅ Start/pauza/reset

✅ Działający sygnał dźwiękowy na 5 sekund przed końcem ćwiczenia

✅ Podsumowanie wraz z informacją o czasie całkowitym

Problemy / niedociągnięcia:

❌ Nieudany projekt interfejsu

❌ Aplikacja wchodzi po uruchomieniu w tryb pełnoekranowy, jest możliwe wyjście przy pomocy klawisza F, bez zatrzymywania aplikacji

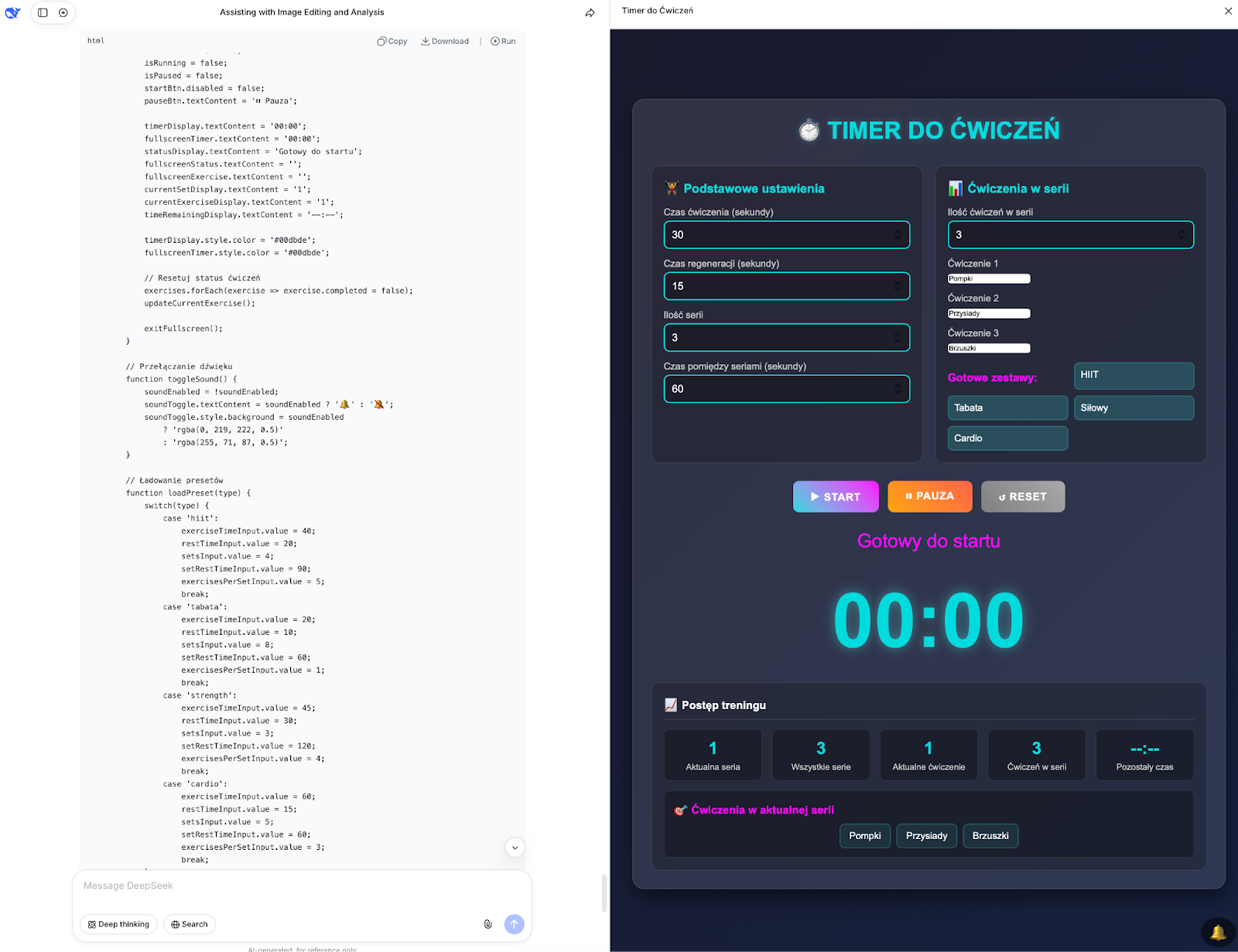

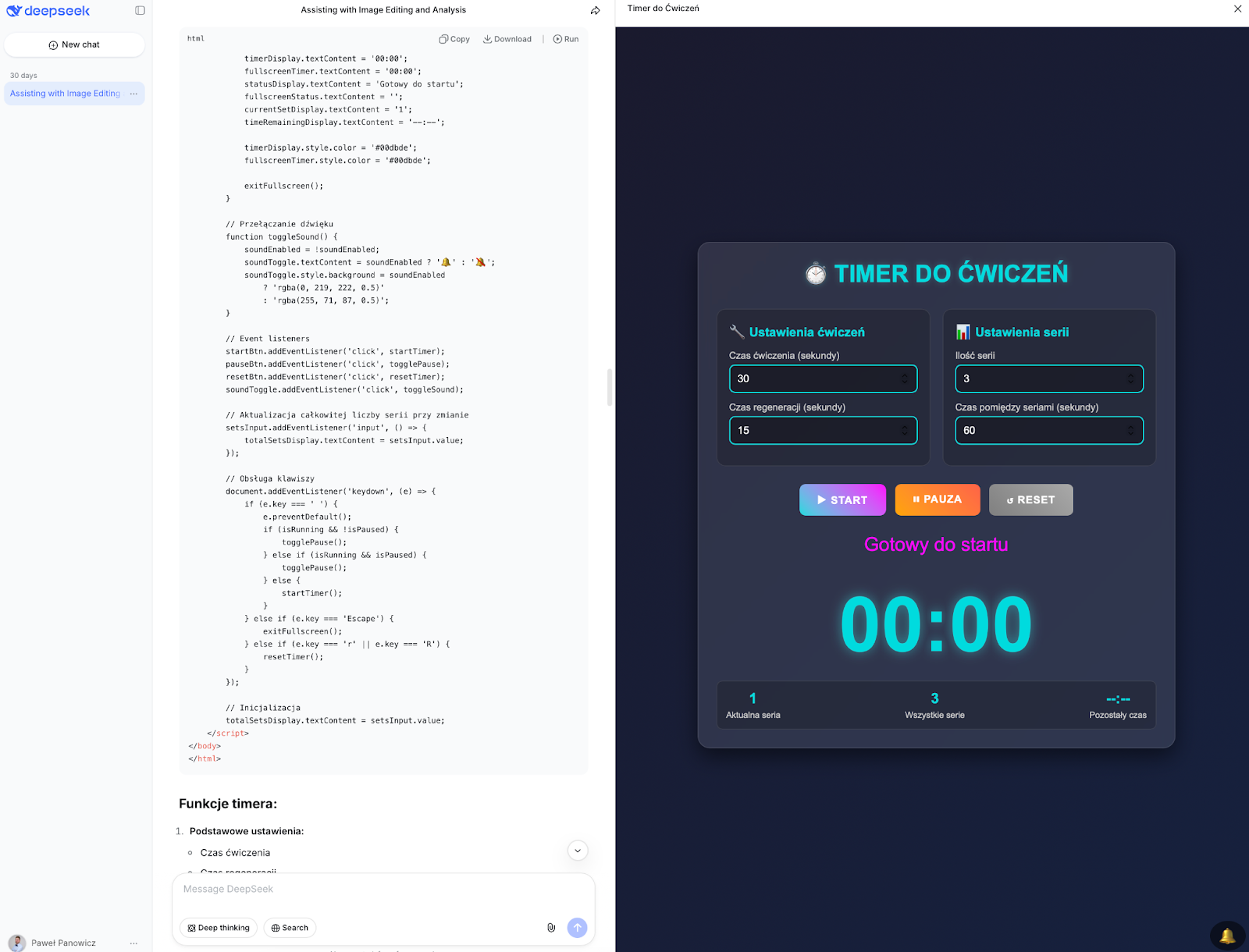

3) DeepSeek — wykonanie timera

Podobnie jak Gemini i ChatGPT, DeepSeek umożliwia odpalenie podglądu aplikacji:

Natomiast nie ma możliwości edycji kodu, dodatkowo, pierwsza wygenerowana aplikacja nie miała możliwości ustawiania ilości ćwiczeń w serii:

Dopiero po prostym zwróceniu na to uwagi:

Brakuje możliwości ustawienia ilości ćwiczeń w serii

DeepSeek dodał tą oraz kolejne funkcje już sam z siebie.

Rezultat:

Działające elementy, pozytywne uwagi:

✅ UI timera

✅ Wszystkie funkcje opisane w instrukcji

✅ Możliwość nazwania każdego ćwiczenia

✅ Możliwość wyłączenia dźwięku

✅ Poprawny sygnał dźwiękowy na 5 sekund przed końcem ćwiczenia

✅ Dodatkowy sygnał dźwiękowy na rozpoczęcie i koniec ćwiczenia

✅ Podsumowanie ćwiczeń, długość całego treningu

Problemy / niedociągnięcia

❌ nie działa przycisk x wyjdź z trybu uruchomionego timera, tylko ESC

❌ Dodane gotowe zestawy ćwiczeń, których nie można zmieniać

❌ Nie działa pauza, blokuje aplikację, trzeba zresetować, aby móc ponownie uruchomić aplikację.

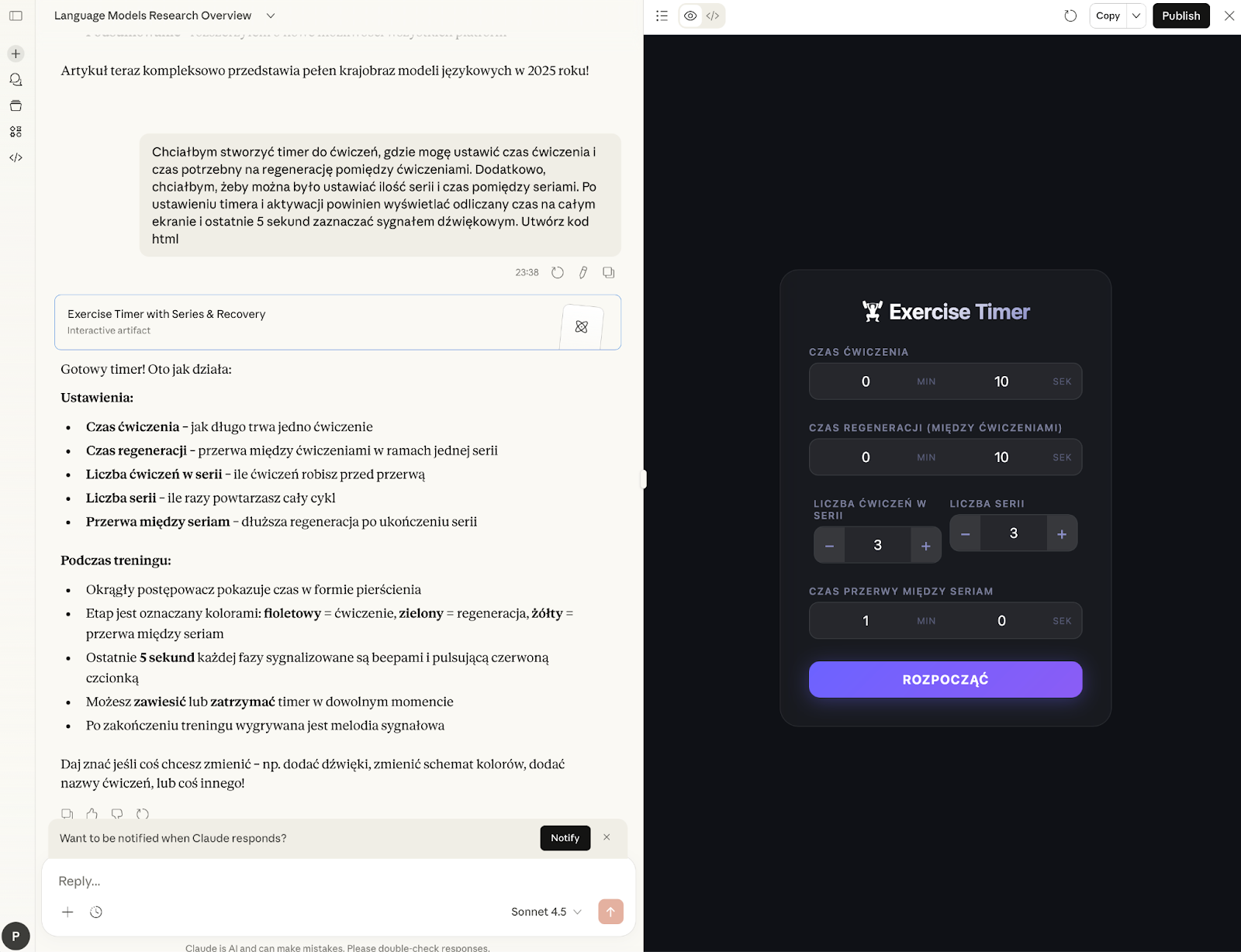

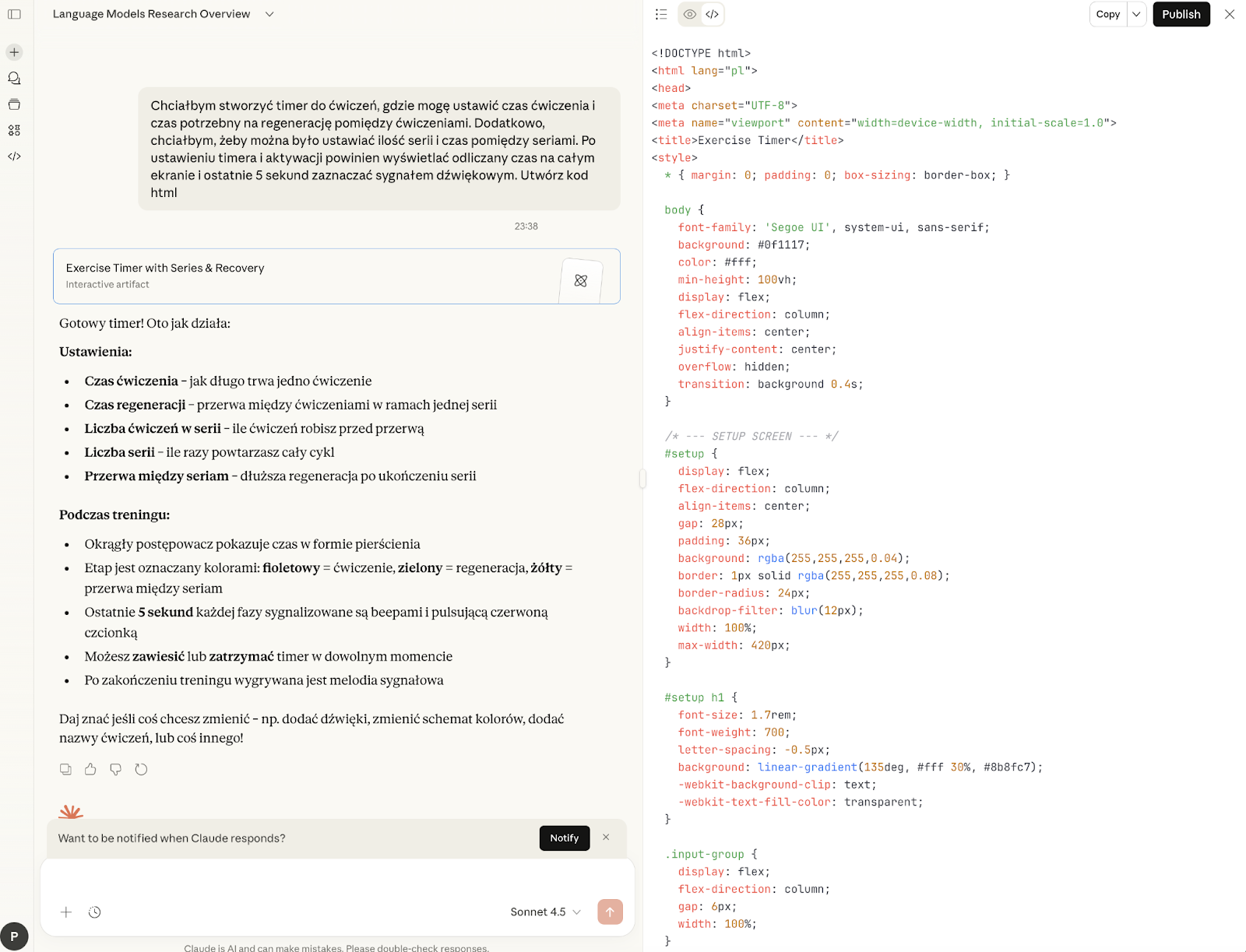

4) Claude Sonnet 4.5— wykonanie timera

Claude ma opinię najlepiej kodującego LLM, używany przez programistów jako zintegrowane narzędzie. Tutaj użyłem darmowej wersji, modelu Sonnet 4.5 (model Opus dostępny jest w wersji Pro).

Tak jak u poprzedników, Claude udostępnia podgląd aplikacji:

Interface Claude’a udostępnia możliwość podglądu kodu aplikacji jednak nie ma możliwości własnoręcznej jego edycji:

Claude umożliwia również opublikowanie aplikacji, powstaje dostępna publicznie strona w domenie claude.ai : https://claude.ai/public/artifacts/b23a1e35-8ff9-4019-9616-f92d12849618

Rezultat:

Działające elementy, pozytywne uwagi:

✅ UI timera

✅ Wszystkie funkcje opisane w instrukcji

✅ Poprawny sygnał dźwiękowy na 5 sekund przed końcem ćwiczenia

✅ Ciekawa animacja po uruchomieniu timera

Problemy / niedociągnięcia

❌ Niedopracowany UI w panelu ustawień timera

❌ Claude słabo radzi sobie z odmianą polskich słów

Porównanie wyników — Zadanie: Timer do ćwiczeń

Głównym założeniem było sprawdzenie, czy laik może stworzyć w pełni funkcjonalną aplikację (Timer do ćwiczeń), opierając się wyłącznie na promptach, bez dotykania kodu w IDE. Modele musiały samodzielnie zaprojektować logikę, UI (User Interface) oraz obsłużyć interakcje i błędy.

Testowane modele:

- ChatGPT 5.2 (OpenAI)

- Gemini 3 (Google)

- Claude (Sonnet 4.5)

- DeepSeek

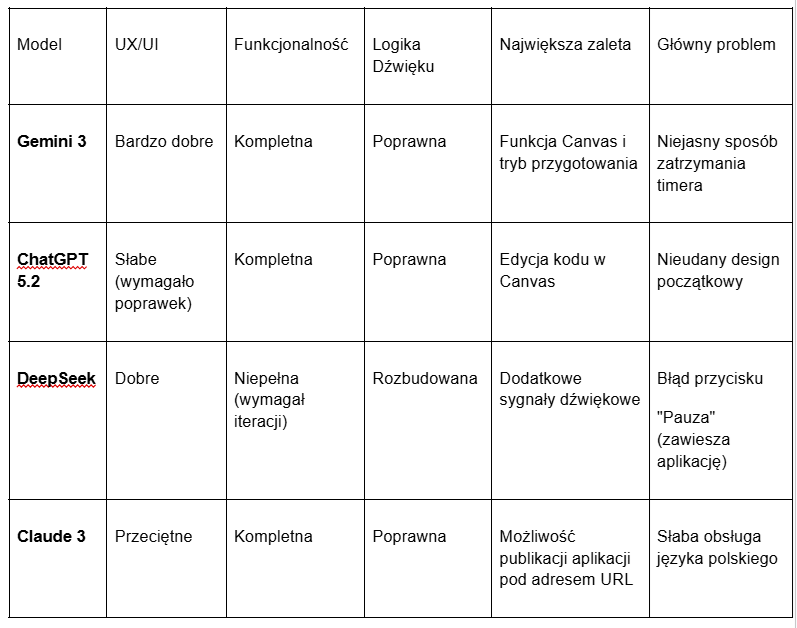

Poniższa tabela przedstawia, jak poszczególne modele poradziły sobie z kluczowymi elementami zadania:

Szczegółowe wnioski z przebiegu testu

Gemini 3

Model od Google okazał się najbardziej wszechstronny. Jako jedyny zaproponował ekran "przygotuj się" przed startem ćwiczeń i najlepiej zintegrował proces tworzenia z narzędziem Canvas. Gemini bez problemu skonwertowało kod z React na czysty HTML/JS, zachowując przy tym wysoką jakość UX.

ChatGPT 5.2

Choć funkcjonalnie aplikacja była poprawna, ChatGPT zawiódł w warstwie wizualnej. Design wymagał dodatkowych promptów ("Zmień design na bardziej przyjazny"), a wymuszony tryb pełnoekranowy okazał się mało intuicyjny w obsłudze.

DeepSeek

Model ten wykazał się "własną inicjatywą", dodając funkcje, o które nie proszono (np. nazywanie ćwiczeń). Niestety, poległ na fundamentach — pierwsza wersja była wybrakowana, a finalna posiadała krytyczny błąd logiki, w którym pauza trwale blokowała timer.

Claude 3 (Sonnet 4.5)

Potwierdził opinię świetnego "kodera", dostarczając stabilną aplikację z ciekawymi animacjami. Ogromnym plusem jest funkcja Publish, która pozwala udostępnić gotowe narzędzie światu jednym kliknięciem, jednak model gorzej poradził sobie z estetyką panelu ustawień i polską gramatyką.

Konkluzja: Czy to już "Zero Code"?

Test udowodnił, że w 2026 roku stworzenie działającego prototypu bez wiedzy technicznej jest możliwe, ale proces ten nie jest jeszcze bezbłędny.

- Gemini 3 wygrywa procesem tworzenia (workflow) i intuicyjnością.

- Claude dominuje w łatwości dystrybucji gotowego rozwiązania.

- DeepSeek i ChatGPT wymagają jeszcze dopracowania stabilności generowanego UI/UX.

Wspólnym wyzwaniem dla wszystkich modeli pozostaje utrzymanie idealnej logiki po wprowadzeniu poprawek oraz projektowanie interfejsów, które nie wymagają "ręcznego" retuszu.

Zapowiedź kolejnej części serii

W kolejnej odsłonie Wielkiej czwórki AI – Crash Test skupimy się na agentach danych: zadaniach, które wymagają pracy z plikami, analizą, wykrywaniem anomalii i przygotowywaniem wynikowych artefaktów (Excel/raport). To obszar, w którym elokwencja przestaje wystarczać, a liczy się spójność logiki i kontrola nad procesem — podobnie jak w matematyce i programowaniu.

Zarezerwuj czas z ekspertem - dołącz do inicjatywy Masterclass!

Cyfrowa transformacja i skuteczna komunikacja wewnętrzna w organizacji to dziś nie tylko modne hasła - to realna przewaga konkurencyjna. Dlatego w ramach naszego projektu uruchamiamy nową inicjatywę: Masterclass - platforma wiedzy oraz dostęp do ekspertów , które mają na celu wspieranie członków organizacji w kluczowych obszarach rozwoju technologicznego, operacyjnego i strategicznego.

Czym jest Masterclass?

Masterclass to dostęp do bazy wiedzy, artykułów eksperckich, warsztatow, konsultacji, dopasowane do realnych wyzwań, z którymi mierzą się firmy - zarówno te małe,średnie jak i duże. Każde spotkanie to okazja do zadania pytań, wspólnego rozwiązywania problemów oraz zdobywania praktycznych umiejętności.

Tematyka obejmuje m.in.:

- IT

- AI

- Marketing/ PR

- ESG

- Księgowość

- Podatki

- Prawo

- HR

Dlaczego warto się zgłosić?

Każda firma jest inna - dlatego oferujemy możliwość rezerwacji indywidualnego czasu z ekspertem. Dzięki temu możesz omówić konkretne potrzeby swojej organizacji i otrzymać spersonalizowane rekomendacje. Nasi eksperci mają wieloletnie doświadczenie w pracy z firmami z różnych branż - od produkcji, przez usługi, po sektor publiczny.

Jak to działa?

- Wybierasz dogodny termin spotkania.

- Określasz interesujący Cię temat lub wyzwanie, które chcesz omówić.

- Bierzesz udział w 60 minutowej sesji (online lub hybrydowo).

- Otrzymujesz podsumowanie, materiały i plan dalszych działań.

Chcesz więcej?

W ramach Masterclass organizujemy interaktywne warsztaty, jeśli masz pomysł na temat takich warsztatów skontaktuj się z naszymi ekspertami.

📅 Zarezerwuj swój czas już dziś!

Sprawdź dostępność eksperta i wypełnij formularz na dole strony eksperta https://www.zig.pl/eksperci

Nie zwlekaj - liczba miejsc na indywidualne konsultacje i warsztaty jest ograniczona. Masterclass to przestrzeń, w której wiedza spotyka się z praktyką - dołącz do niej razem z nami!